如何在阿里云试用计划中白嫖算力?深度学习服务器试用步骤详解

深度学习领域如今备受瞩目,然而其中一大难题便是其对算力的极高需求。面对庞大的数据集和复杂的模型,如扩散模型等,普通学生往往连训练过程都无法亲身体验,这主要是因为所需的算力成本高昂。于是,免费获取算力成为了众人关注的焦点,这一做法既存在争议,又让人感到无奈。

深度学习的算力需求

在深度学习领域,模型结构复杂,通常拥有庞大的参数数量。例如,一些著名的图像识别模型,其参数数量可能高达数亿。如此大规模的数据处理和推断过程,对算力消耗极大。在商业领域,企业为了开展深度学习项目,往往需要投入大量资金来搭建高性能的集群。而对于个人,尤其是学生来说,这样的投入实在是力不从心,使得许多人无法踏入深度学习的大门。而且,随着技术的进步,模型参数还在持续增长,对算力的需求也在不断攀升。

深度学习应用广泛,其中多模态任务集成了多种数据类型。此类任务对算力的需求不断增长,许多人虽然充满热情,却因算力限制而难以深入探究。

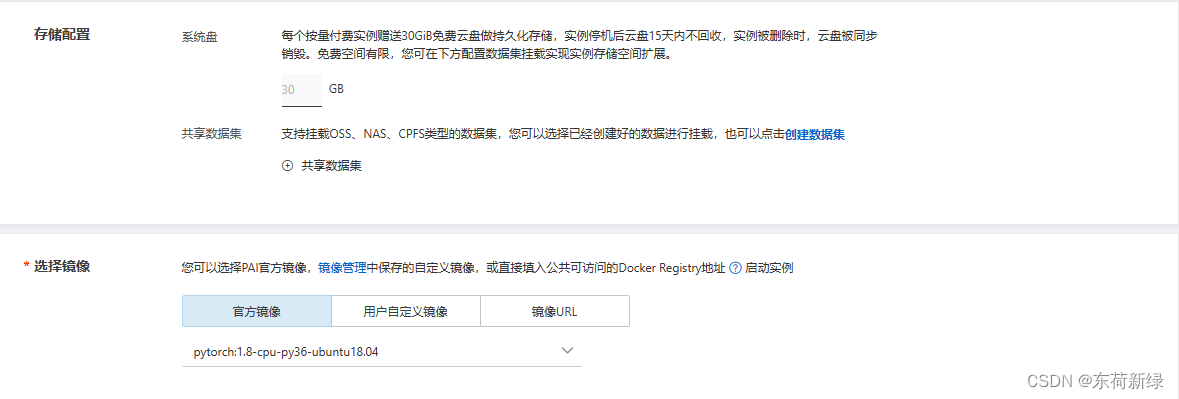

阿里云试用计划

阿里云推出了免费试用算力的方案,即试用计划。这对于经济条件有限的学者和学生来说,无疑是个宝贵的机遇。该活动的截止日期是8月31日,且仅限新用户参与。只需注册一个账号,即可开始体验其深度学习服务器。但需留意,它与普通服务器存在细微差别,使用前请务必仔细阅读相关操作步骤。

这个试用计划让大家有机会亲自动手,深度学习不再是遥不可及。许多人能借此机会,运行一些参数规模较小的模型,完成基础学习或小项目实践。

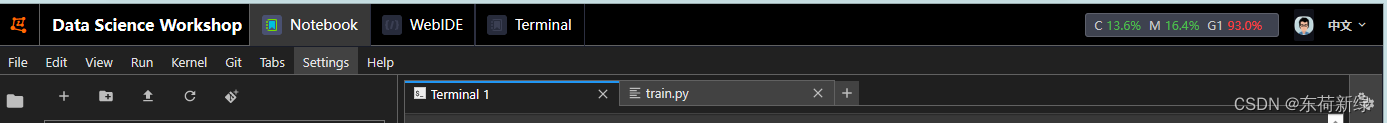

使用中的问题NoCUDAGPUsare

使用阿里云的深度学习服务器时,有时会遇到“没有可用的CUDAGPU”的问题。这个问题通常出现在.to()操作中。与此同时,torch却显示cuda可用,这种矛盾现象让人感到困惑。由此可以看出,在使用阿里云服务器时,可能会遇到一些技术性的bug。这要求用户具备一定的技术能力,以便分析和解决这些问题。

面对这个问题,许多人可能会感到迷茫,不知如何是好。然而,实际上,这种技术难题在刚开始使用新平台时是很常见的现象。这恰恰说明了在新环境适应过程中,我们面临的一些挑战。

详细报错内容

报错内容详尽,揭示了问题发生的具体环节。它能清晰地指出问题发生的具体步骤。正确理解报错信息,是解决问题的核心步骤。比如,若指出问题出现在某个特定的脚本转换操作中,就能帮助用户精确找到问题所在。

明白这些错误信息,使用者便能更有效地预防类似错误。各种报错反映了不同的问题根源,若需对模型或操作进行调整,它们同样能提供宝贵的参考。

解决问题

遇到类似问题时,依照这些方法操作,能大大节省时间,无需再进行无效的探索。这无疑是宝贵的经验之谈。

torch._C._cuda_init() No CUDA GPUs are available

总结感谢

文章内容或许存在不足,这很正常,因为每个人的见识都是有限的。在总结整个过程的经验时,我们不可避免地需要借助众多人的力量。因此,我们应当真诚地向那些给予帮助的人表达感激。这不仅是一种礼貌的体现,也是对大家无私分享知识的尊重。同时,我们也希望将这些知识传递给更多的人,让更多的人从中受益。

torch.cuda.is_available() # true

torch.cuda.device_count() # 1

作者:小蓝

链接:https://www.lanmiyun.com/content/3706.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发