谷歌 I/O 大会公布第二代 TPU,内部使用,细节披露

谷歌的TPU2硬件宛如一座深藏不露的宝藏,知晓其存在的研究人员寥寥无几,他们能通过TRC直接触及。这个“高度选择性”的项目,充满了诸多谜团。单是这一点,就足以令人称奇。如此独特的资源,为何对其访问设有如此严格的限制?

TPU2与TRC的关系

TPU2的研究云(TRC)仅供少数人访问,这通道显然是为研究人员量身打造的。这表明谷歌对TPU2项目有着明确的目标定位。它并非面向大众,而是专门为那些专注于特定领域的研究者开放。这与大众可以随意使用的云计算资源有着根本的不同。此外,TRC如同一个门槛,限制了TPU2用户的范围。在硬件访问机制中,这显得格外特别,使得TPU2宛如深藏不露的珍贵宝石。

这种做法只允许极少数人通过TRC访问TPU2,这难道不是限制了其潜在价值的深入挖掘吗?

TPU2连接的隐藏性

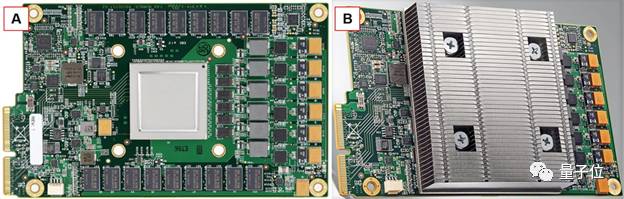

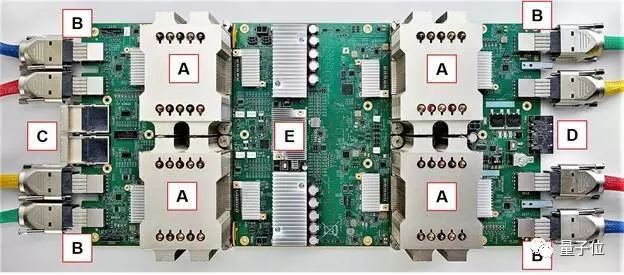

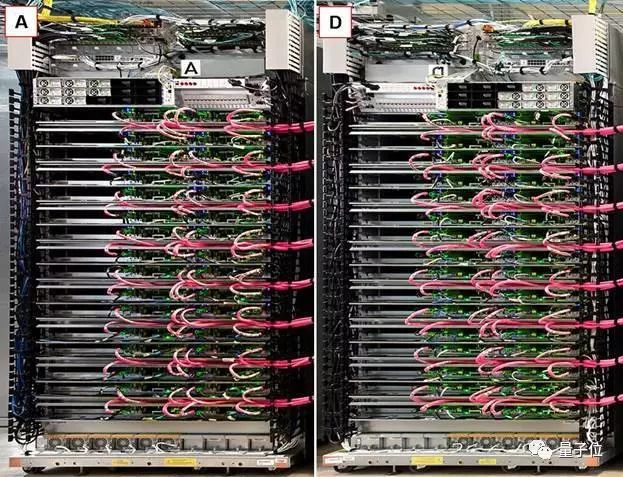

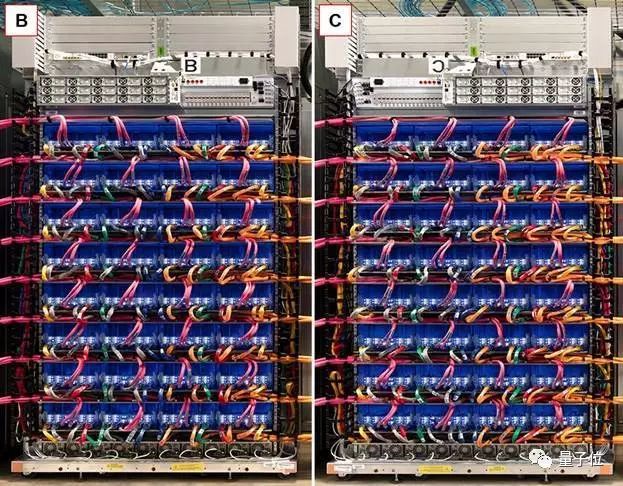

在主板处理能力或PCI-E吞吐量未超负荷之前,谷歌从未公开透露连接到服务器主板上的TPU数量。这种隐秘的做法让人难以捉摸。谷歌此举或许出于多方面考量。一方面是为了技术层面的保密,另一方面或许是为了减少外部干扰。而且,即便是在将每个TPU2板连接到两个处理器板的过程中,谷歌也不希望增加自身对拓扑结构的安装、编程和调度复杂性的混淆。这种复杂的连接方式,在硬件领域堪称独树一帜。

难道隐藏TPU2连接状况就能保证其安全性和稳定性的提升吗?

TPU2与至强芯片的配比

TPU2芯片与至强处理器之间的比例是2比1,这与GPU加速器在深度学习任务中的4比1或6比1的比例有着显著差异。这表明TPU2与处理器之间存在着紧密的耦合关系。据推测,这个2比1的配比可能是谷歌经过大量实验得出的最佳比例。不同的配比在数据处理速度和能效等方面会产生不同的影响。特别是在深度学习任务的数据运算和处理上,这种配比或许能展现出更高的效率。

这种配比与传统的GPU加速器配比相较,是否预示着未来硬件配比的新潮流?

机柜内硬件关联

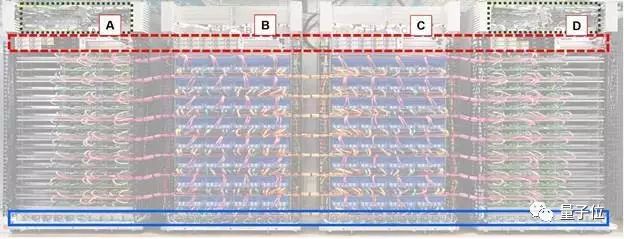

TPU2机柜内部的联系相当神秘,我们并不清楚一个机柜中的CPU与TPU2芯片是如何相互连接的。TPU2芯片在共享数据时,还需依赖超网格的连接。处理器池本应提供机柜的超网格拓扑图,以便明确哪些TPU2芯片能够用于执行任务。这种模糊不清的连接方式,是谷歌技术中的一个谜团,外界难以知晓其具体的逻辑和运作机制,或许这与核心技术的保密策略有关。

在难以弄清楚CPU和TPU2芯片在机柜内是如何相互关联的情况下,我们能否推测出它们之间关联的大致原理?

TPU2运算处理模式的优势

TPU2芯片无需处理多任务、虚拟化或多租户,柜上的运算任务由CPU承担。这种运算处理方式颇具特色。它使得TPU2能专注于特定任务,将复杂的管理和多任务处理工作交给CPU。这样做减轻了TPU2的工作负担,同时充分发挥了CPU在管理方面的优势。在运算处理过程中,这样的安排有助于提升整体运算效率和资源分配的合理性。

CPU负责统一管理复杂事务,而TPU2则专注于运算,这种模式能否应用到其他硬件设备上?

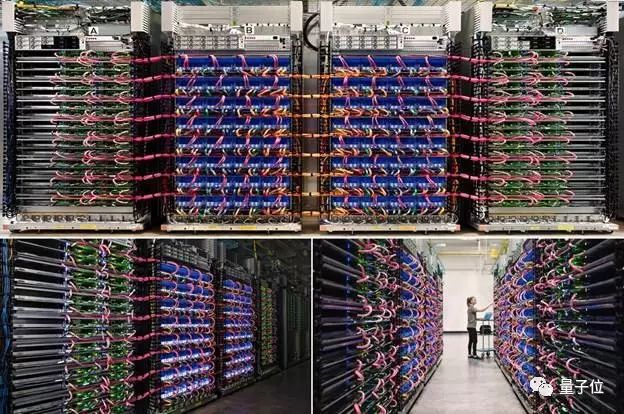

TPU2的性能与比较

研究人员虽然能够连接到一定数量的TPU2芯片集群,但要扩展到整个机柜却面临挑战。每个机柜都有其特定的性能表现,比如FP16运算能力在每瓦100至115之间。然而,目前尚无足够的信息来将TPU2机柜与英伟达Volta等商用产品进行对比。谷歌的TPU2从第一代到第二代,其与CPU的关系发生了变化,但在市场比较方面,却缺乏足够的信息来明确其定位。

在信息不足,无法与其他产品进行对比的情况下,TPU2的市场价值又该如何进行准确的评估?

对TPU2硬件的这些特性感兴趣的话,不妨点赞、分享这篇文章。同时,也欢迎在评论区展开讨论。

作者:小蓝

链接:https://www.lanmiyun.com/content/3746.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发