深度神经网络(DNN):准确性高但计算复杂,效率与吞吐量待提升

深度神经网络在语音识别与图像识别领域实现了重大突破,随后相关应用如雨后春笋般迅速增长。这一现象背后,隐藏着许多令人耳目一新的知识点,实为深入研究的宝贵素材。

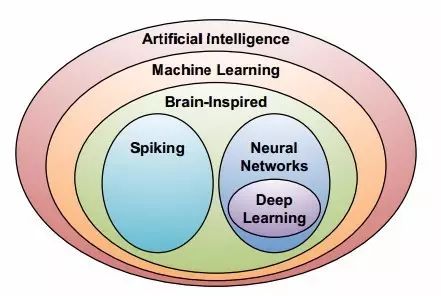

DNN兴起的背景

过去,专家们必须手动提取特征或制定规则,这样的做法既费时又费力。但深度神经网络(DNN)的问世,彻底改变了这一状况。它凭借在大量数据上运用统计学习技巧的能力,崭露头角。在众多科研项目中,过去依赖人工分析样本特征,效率十分低下。而DNN能够自动从原始数据中提取高级特征,显著提高了处理速度和准确性。这一转变充分说明,技术革新往往源于对更高效率和效果的追求。各行各业都迫切需要这种高效的数据分析手段,DNN恰好满足了这一需求。

DNN计算加速方法的研究

研究人员目前主要关注的是为DNN计算开发专门的加速技术。DNN在处理海量数据时,计算量十分庞大。特别是在医疗影像识别领域,每次处理数千甚至数万个影像数据,如果运算速度过慢,就会导致诊断结果延迟。因此,开发加速方法变得尤为迫切。众多科技公司和研究机构纷纷投入大量人力和财力进行相关研究。有些团队致力于优化算法逻辑,而另一些团队则致力于硬件改进,努力寻找更适合DNN运算的硬件架构,以期提高运算速度,使DNN能更好地服务于各行各业。

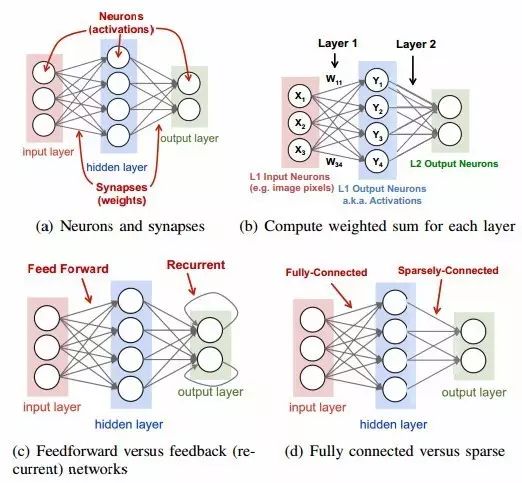

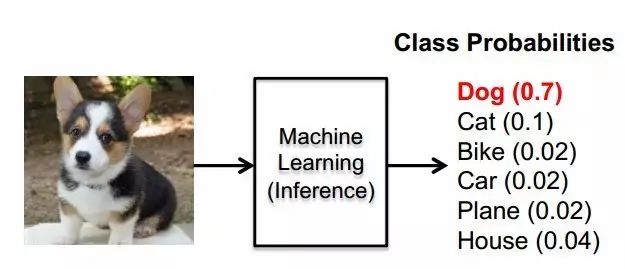

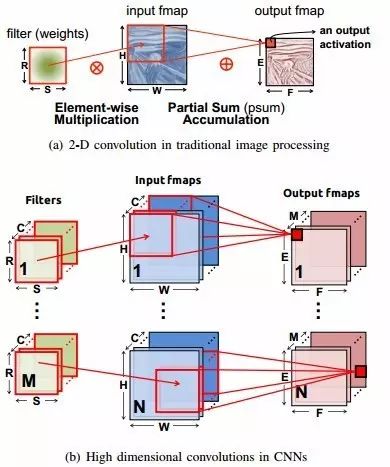

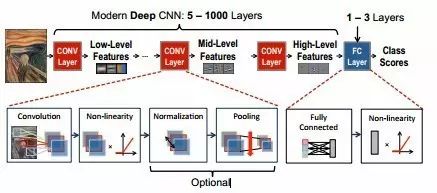

DNN的工作原理

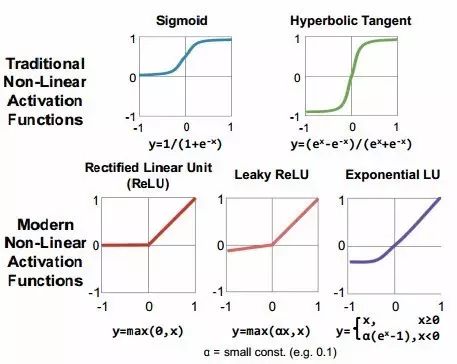

机器学习算法只需经过训练,就能处理某一领域的新问题,而不需要特定的编程。神经网络的工作原理是,基于输入值进行加权,并应用非线性函数。以图像分类为例,图像的像素数据首先输入网络的第一层,通过加权可以提取出低阶特征。在训练过程中,网络会根据这些低阶特征,结合高阶特征,给出对象的概率,也就是分类结果。这个过程就像一个智能的分拣机,不同的特征就像是不同的分拣标准,按照既定的逻辑,将对象分到不同的类别。在其他领域,如文本分类等,也遵循着类似的逻辑。

DNN的训练目标与反向传播

训练深度神经网络的核心任务是确定一套合适的权重,以实现大规模数据集损失的最小化。在此过程中,梯度的计算通过反向传播技术得以高效实现。以交通流量预测的DNN训练为例,需依据海量的历史交通流量数据来寻找最优权重。为了确保预测结果的偏差尽可能小(即损失最小),反向传播算法持续调整权重。损失值的影响会反向传递,通过网络评估来衡量权重对其的影响。这一过程不仅需要大量的计算资源,还需要丰富的数据样本,同时对于权重的初始设置等也极为敏感。

无监督学习与深度学习框架

无监督学习是DNN中不可或缺的技术,其训练样本不带有标签,主要目的是寻找数据中的结构或进行聚类。这种方法促进了众多深度学习框架的进步,而且这些框架大多都是开源的。因此,众多研究者和从业者能够轻松地运用DNN网络。在探索未知的数据分析领域,无监督学习展现出强大的能力,比如在寻找宇宙信号的来源上,由于许多信号都是未知的、无标签的,无监督学习便能够挖掘出潜在的结构。此外,开源框架的普及降低了使用门槛,使得更多的人能够参与到DNN的研究和应用开发中。

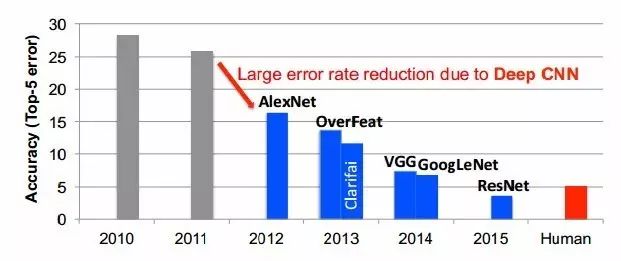

DNN的性能优化与发展

DNN的发展历程中,涌现出众多优化策略。例如,ReLU及其变体函数已被证实能提高模型准确性,因此越来越受到青睐。此外,通过将某些激活函数之间的连接权重设为零,可以减少参数数量,同时不影响准确性。在嵌入式平台应用中,面临着严格的能耗、计算和存储成本限制。2012年,多伦多大学的研究团队利用图GPU技术,将错误率降低了约10%。而且,不同网络结构之间可以相互借鉴优化经验。例如,若某网络与另一结构相似,适当调整滤波器数量,就可能提升准确度。这些因素共同推动了DNN向更优方向发展。

阅读了这些关于深度神经网络(DNN)的资料后,我们是否思考过,DNN将来会如何深刻影响我们的日常生活?期待大家积极点赞,转发这篇文章,并在评论区留下你的见解。

作者:小蓝

链接:https://www.lanmiyun.com/content/4954.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发