SQL与Spark数据类型兼容性问题及解决方案详解

在当前的数据处理行业,企业们追求提升性能、解决兼容性问题以及控制成本等目标,这一过程充满了挑战和意外的收获。以CDH5升级至CDH6的集群为例,其中的变化确实值得详细研究。

集群升级带来的性能提升

在CDH5到CDH6集群升级初期,计算引擎由Hive升级至HiveOnSpark。这一改动显著提升了性能,增幅相当可观。这意味着在完成相同任务时,所需时间大幅减少。节省的时间直接转化为生产力的提升。同时,还解决了众多兼容性问题,包括SQL语法、UDF、数据文件格式和运行参数等,使数据处理流程更加流畅稳定。

集群升级并非易事,需全方位考量。企业需投入人力和物力进行迁移测试,以防数据丢失等风险。尽管升级有许多益处,但过程并不轻松。

Canal数据解析与处理

在IDC中,Canal扮演着关键角色。它负责解析Sink数据,并将其发送至Kafka。这样的处理方式,有助于实现上下游系统的解耦。一旦上下游系统实现独立,那么它们各自的升级或修改,就不会对彼此造成太大的影响。

在这种架构中,实现数据回溯变得相对简单。我们能够获取到Kafka在特定时间点的消费数据,这对追溯历史数据、追踪错误数据的来源非常有益。工程师在此过程中需细致设置Canal与Kafka的连接,确保数据传输既准确又迅速。任何配置上的失误都可能导致数据传输中断或数据丢失。

原始数据处理的困境

原始数据通常不能直接用于制作业务报表。企业常常需要对这些数据进行大量加工,这本身就是一个不小的挑战。比如说,不能直接利用Kudu的原始表来提供查询服务。尽管Kudu有其优势,但在成本、性能和扩展性等方面,仅凭Kudu构建数据仓库并非最佳选择。因此,企业需持续寻找新的数据处理方式,以满足业务报表的制作需求。

面对庞大的数据处理需求,问题愈发明显。数据处理的计算需求很高,若在此投入过多资源,将对企业整体效益造成影响。

Hudi的优势与应用

Hudi是处理数据问题的有效方法。它对数据处理中的某些功能提供了出色支持,比如能够实现接近实时的分钟级延迟写入。这种特性在那些需要快速更新数据但又不允许实时性要求过高的场合特别有用。此外,它还具备多种灵活机制,例如支持乱序数据导入、部分字段更新和自定义操作等。

在实际应用中,例如在Flink进行多表连接操作时,我们可以利用这些特性来达成目的。这样一来,Flink便无需担忧状态过时和顺序混乱的问题。在企业层面,采用Hudi能够提升数据处理的效能与适应性。然而,配置与运用Hudi确实要求技术人员具备一定的专业素养。

Spark写入操作与性能优化

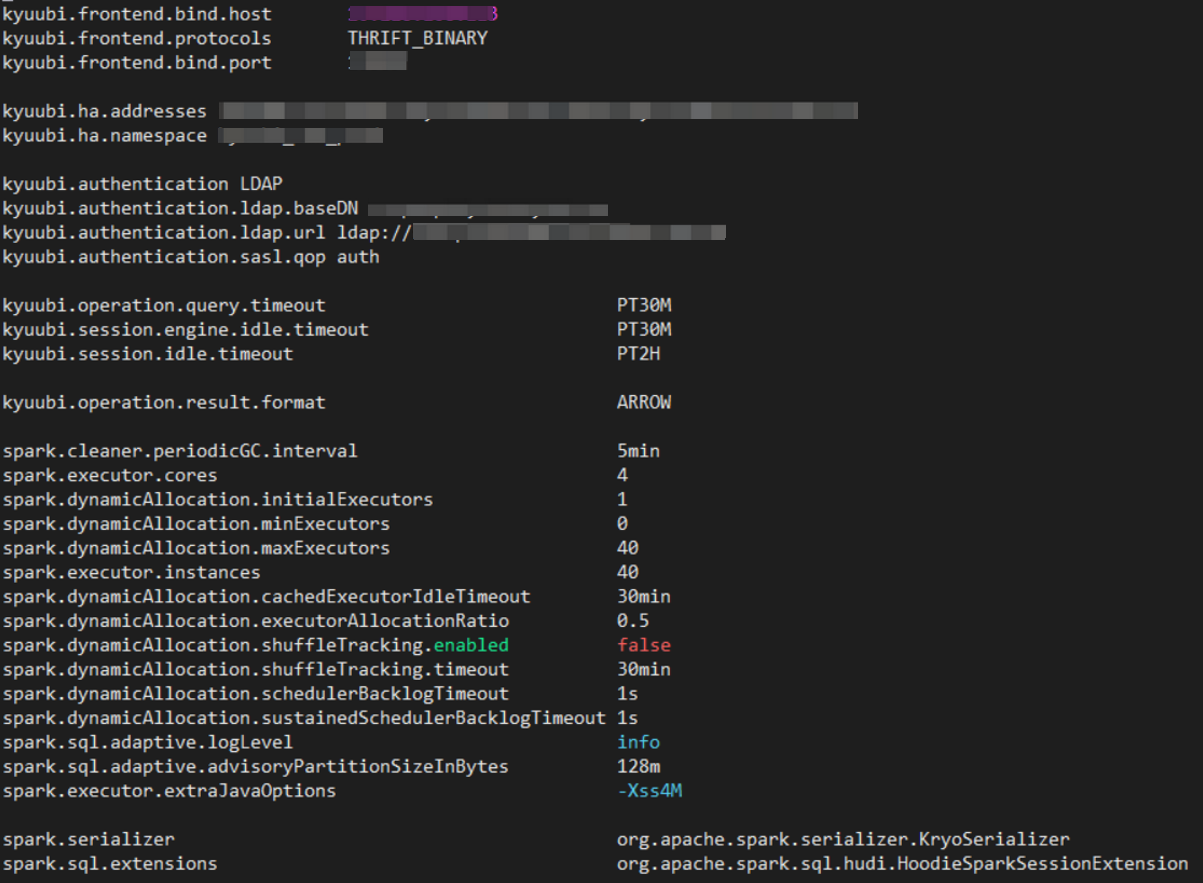

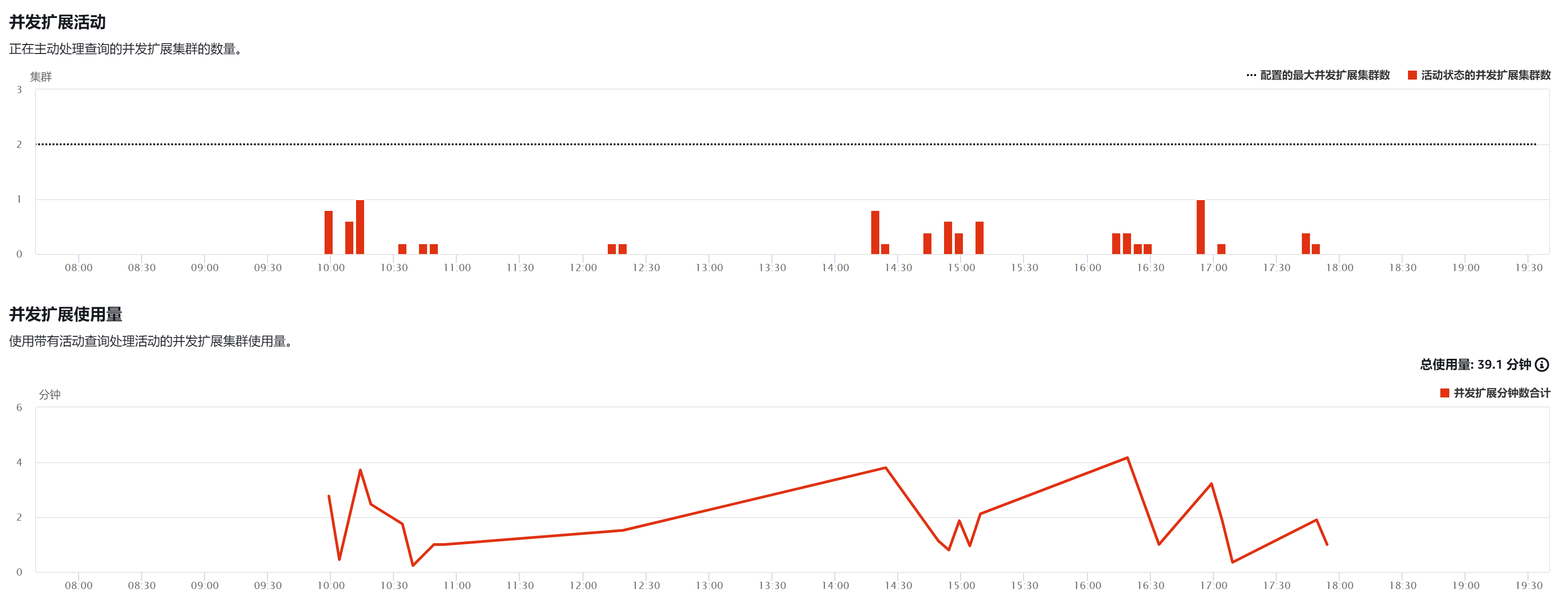

在处理数据时,我们通过Spark读取Kafka上多个主题的变更数据,并将其写入到900张Hudi表中。在此过程中,尝试用Spark作业并行写入这些表,启动多个线程以加速操作。然而,快速恢复和业务优先级等问题迅速显现。实践表明,单个作业多线程写入多张表的效率并不理想,相比之下,多个作业分别写入多张表的效果更好。这主要是因为EMR对Spark进行了性能上的优化,对源代码进行了调整,但API层仍然与开源版本保持一致。

并发写入涉及文件锁等特殊机制,当对正在执行写入操作的表进行操作时,这种文件锁的设置确实带来了方便。另外,在Spark写入Hudi的过程中,参数的调整同样关键。例如,适当地提升某些参数的数值,将某些参数设置为真,以提升数据集的检索效率。

硬件成本的降低与整体方案优势

采用Hudi方案后,与EMR集群共享计算资源显著降低了成本。硬件费用较之前减少了75%以上,这一降幅令人瞩目。此外,它还能实现接近实时的写入,每分钟延迟极低,这对于数据新鲜度和成本控制都是一大优势。利用S3作为数据湖,数据得以在多种计算引擎间自由流动。这样的设计使得不同计算引擎间的数据共享和协同处理效率大大提升。

末了,我想请教大家一个问题:在处理数据时,是否也遇到过性能有所提高却遭遇其他难题的情形?期待大家的踊跃留言交流,同时也很乐意看到大家对这篇文章的点赞与转发。

作者:小蓝

链接:https://www.lanmiyun.com/content/5090.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发