深度学习环境搭建与远程数据传输解决方案详解

在深度学习领域,人们常用远程云服务器进行研究,但这其中存在的难题却让许多人感到头疼。比如,环境的搭建、保存以及数据的远程传输,这些问题处理起来都挺复杂。

深度学习环境搭建之镜像选择

阿里云等云服务平台上购买服务器并创建实例时,用户可以选择预配置的镜像。这样做有几个优点,比如能减少搭建环境以及安装显卡驱动所需的时间。记得2018年我进行一个图像识别项目时,就是选择了现成的镜像,前期准备工作非常迅速。不过,这种方法也有其局限性。比如,若对深度学习框架的版本有特定需求,可能会遇到一些麻烦。就有一位同事因此在使用过程中遇到了软件兼容性的问题。

自己动手搭建环境,别忘了安装必要的框架,比如TensorFlow或PyTorch,还有像numpy这样的数据处理库。同时,显卡驱动也不能忽视,还得留意它们之间的版本匹配。我有个朋友就为此头疼了很久,直到搞清楚CUDA和深度学习框架版本兼容的问题。

深度学习环境搭建之框架与库

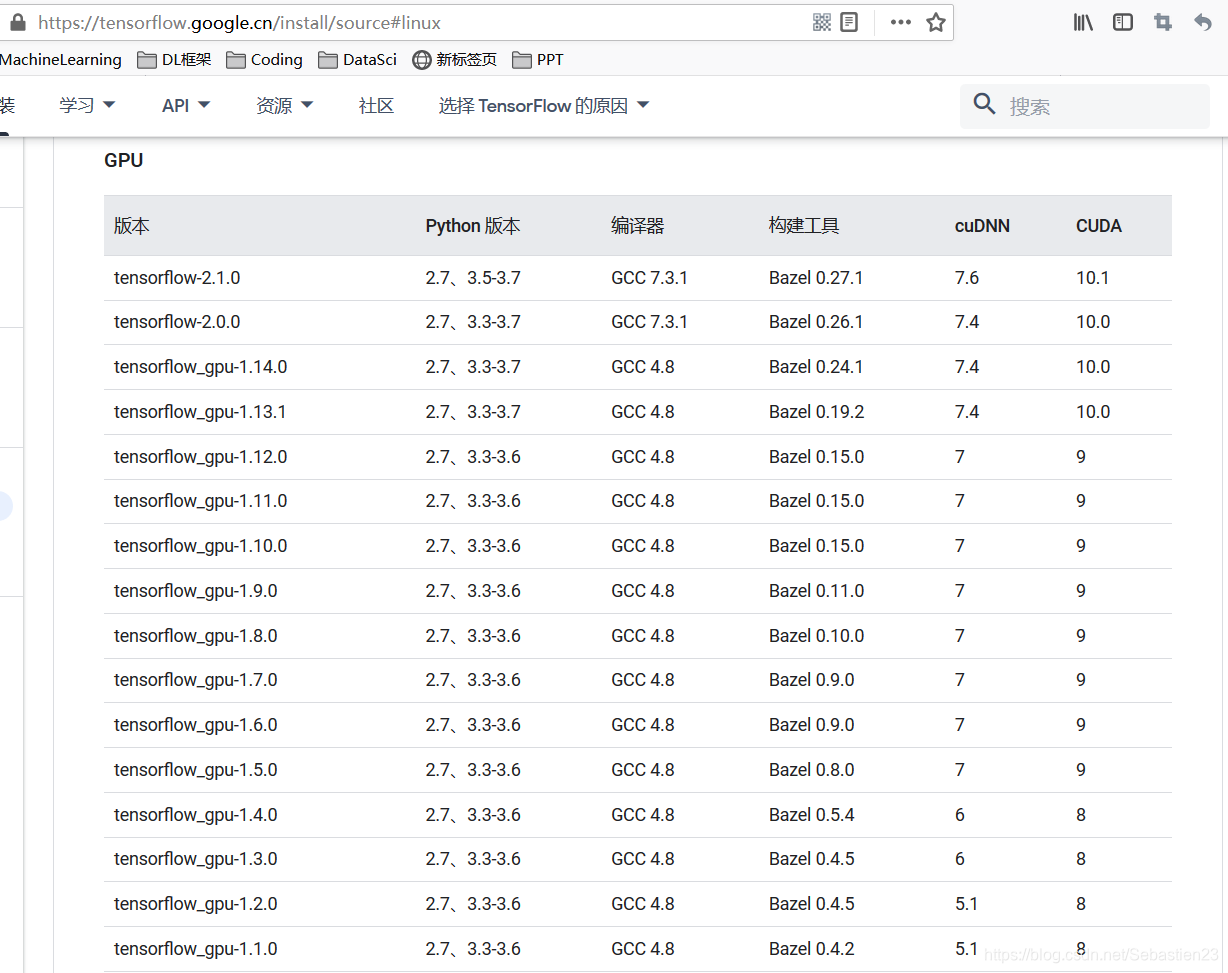

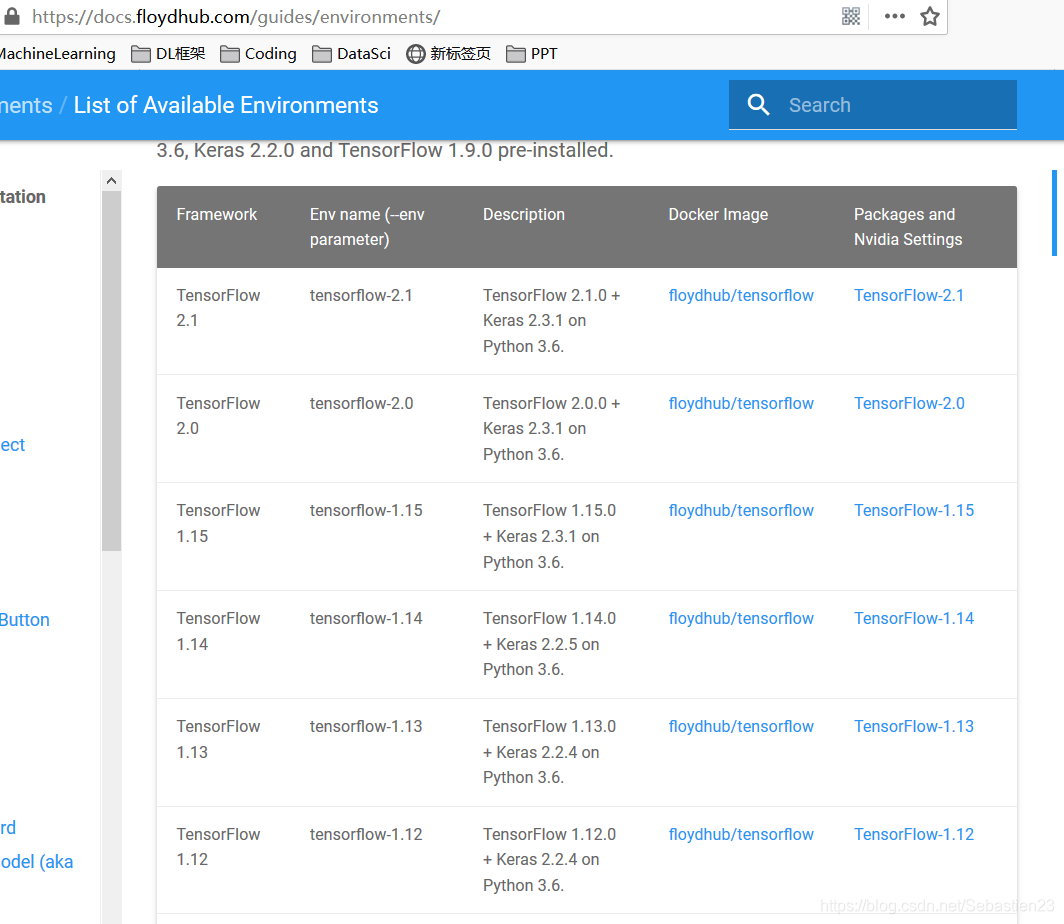

安装深度学习相关框架和库需谨慎。不仅包括之前提到的核心框架,可能还需额外安装如Keras等。这些框架和库间有版本匹配的要求。例如,GPU相关的GCC、CUDA、cuDNN与Keras等,它们的版本必须匹配。2019年我参与情感分析项目时,因未妥善处理版本问题,导致模型训练出错。各版本间就像拼图,一旦某一块出错,整个拼图就无法完成。选择版本时,需综合考虑研究目标和个人数据情况。

安装过程中常常会遇到一些预料之外的问题,例如依赖项不匹配等情况。在这种情况下,我们通常需要上网搜索相关信息或向技术论坛求助。以我之前安装matplotlib库的经历为例,就遇到了依赖项的问题,花费了不少时间才最终解决。

已搭建环境的保存之自定义镜像

自行搭建的环境云服务器,通过制作个性化镜像是一种不错的选择。例如,在进行科研工作时,保存阶段性环境显得尤为重要。这样做可以在实例释放后,快速恢复原有环境。有团队曾因忽视这一点,每次重建环境都耗费了大量时间。制作个性化镜像需遵循既定的操作步骤。

采用按量计费并做好数据备份可以有效减少开支。实验结束后,记得把数据保存在安全的地方,比如个人电脑或远程的安全存储库。这样,你就可以安心地关闭实例,从而节省费用。2020年,有一支新成立的研究团队就因为未进行数据备份,导致数据丢失,不得不从头开始。

创建实例时需挑选恰当的付费模式,例如按需付费。一家初创企业对此尤为重视成本管理,长期坚持使用按需付费,通过巧妙安排工作时间段,节省了大量费用。每次进行实验前,他们都会从自定义镜像启动实例,实验结束后,则依照规定流程进行后续处理。

需结合个人实际情况合理安排实例的释放与创建时间。对于依赖环境较少的简易实验,可适当缩短实例释放的周期。至于那些持续时间较长的项目,在释放实例之前,务必仔细核对数据备份是否完整等相关事宜。

远程数据的传输之后台运行

使用深度学习模型时,若长时间无人操作,网络连接可能会中断。因此,让模型在后台持续运行是很有必要的。记得有一次,我在训练模型时,早上开始连接并启动训练,可中午吃饭回来发现连接已断。后来我才明白,应该让模型后台运行。这样做可以防止软件中断,减少因重新开始训练带来的麻烦。

运行于后台能够有效提升效率。在日常工作之余,人们常交流模型进展,后台运行确保了进程不会因意外而停滞。对于那些有特定显示要求或需实时监控的模型,则需考虑更细致的配置。

远程数据的传输之传输工具

若需进行数据远程传输,使用putty或scp、pscp等软件非常实用。只需在本地系统上安装pscp.exe并将其置于指定文件夹。我们的数据分析师常借助这些软件在本地与云端服务器间进行数据交换。不同操作系统在安装时可能存在差异,需注意相关要求和细节。

传输数据时,安全性同样不容忽视。以涉及隐私的数据集为例,必须保证传输通道的加密措施。当传输大量数据时,速度可能会降低,因此需要对网络带宽做出合理预估。

source activate tensorflow_env # 激活深度学习环境

nohup jupyter notebook & # 后台运行并将数据保存到nohup.out文件中

nohup jupyter notebook --allow-root & # 如果是root用户

ps -aux | grep jupyter # 查看jupyter notebook进程号,假设是1842

kill -9 1842 # 停止后台运行

在使用远程云服务器进行深度学习模型训练时,大家是否遇到了一些独特的问题?欢迎大家在评论区留言、点赞以及转发这篇文章。

作者:小蓝

链接:https://www.lanmiyun.com/content/6043.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发