AI训练数据即将耗尽?2026年或面临数据荒,过度训练成罪魁祸首

人工智能发展迅速,大模型训练所需数据问题日益凸显。一方面,数据短缺的风险日益增加;另一方面,这些数据对于提升模型性能至关重要。这种矛盾现象已成为当前AI领域的一大问题。

大模型训练数据的现状

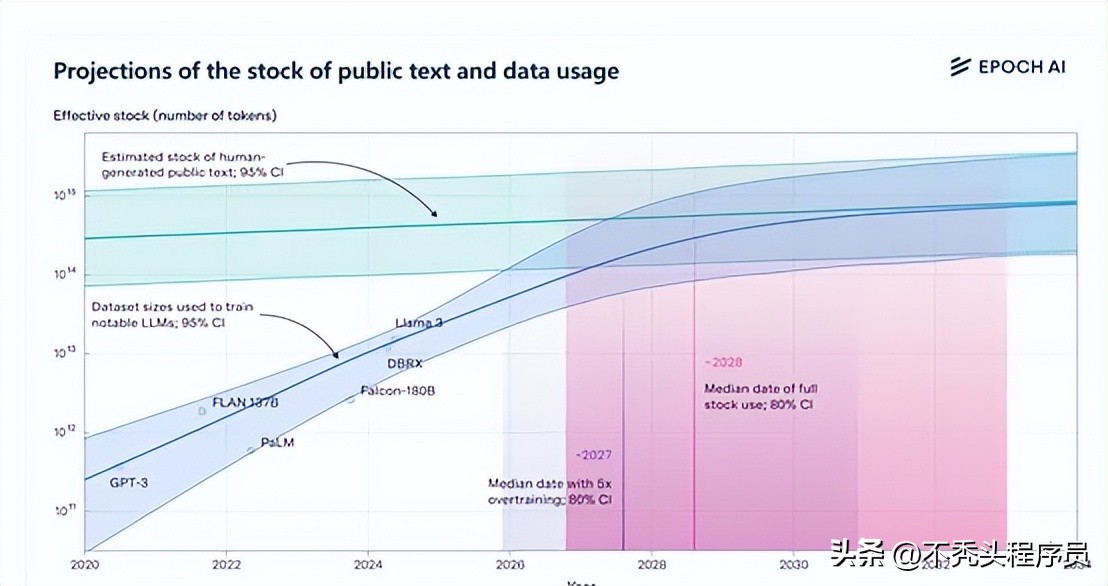

目前,人类公开的高质量文本训练数据集规模已达到约300万亿个tokens。以Meta开源的Llama 3的8B版本为例,它的过度训练量可以达到原始的100倍。这一情况揭示了当前大模型训练数据量极为庞大的现实。同时,在大模型领域,数据的重要性已经和AI算力相当,对模型性能有着决定性的影响。许多企业已经认识到了这一点,纷纷加大在数据领域的投入和研究力度。

在现有数据状况下,过拟合问题同样不可忽视。当模型结构过于繁复,或是训练时间过长时,过拟合现象便会显现。此时,模型会专注于记忆数据中的噪声,而非对新数据做出有效推广。这种情况在实际应用中可能引发风险,因此我们需采取相应措施来加以防范。

过度训练的正负影响

在深度学习领域,尤其是在训练大型模型时,人们常常故意让模型过度训练。这种做法有利有弊,好处之一是可以减少推理所需的时间和提升处理速度。采用这种策略,模型能更好地识别出训练数据中的噪声和具体信息,而不仅仅是掌握数据的一般规律。

然而,这同时也引发了一些问题。若开发者将比例提升至超出理想范围,训练阶段对数据的需求便会上升。若持续使用此训练方法,有预测指出,数据可能在2025年面临枯竭。这对整个行业而言,既构成了巨大挑战,也潜藏了风险。

合成数据的优劣

深度学习常用来复制现实数据,以此来制造新的数据。当数据不够用的时候,这种方法特别重要,因为它能大大增加数据量。但这种方法也有它的缺点。制造出来的数据可能不够好,还容易导致过度拟合的问题。

合成数据难以充分展现真实数据的复杂与多样。这可能是因为它未能准确捕捉到真实文本中的细微语言特征,或者是因为过度依赖单一数据集,结果使得文本的多样性不够。尽管存在这些不足,合成数据依然是多模态大模型训练的重要方式之一。

数据搜集相关努力

科技公司正致力于在数据领域寻求突破。以OpenAI为例,它设立了数据合作组织,目的是搜集高质量的个人数据,用于GPT系列模型的训练。此外,迫切需要研发新的技术手段和方法,确保能高效地收集、整理和规范这些个人数据,使其满足训练标准。这一过程无疑充满挑战,需要攻克众多技术难题。

同时,我们得重视数据的合规与保密,尤其是那些未对外公布的个人资料。若处理不善,可能会触发侵犯用户隐私等权利的隐患,从而对公司形象和信誉带来严重伤害。

与现实世界互动学习的意义

大模型与真实世界的互动学习方式很有价值。它与以往仅依赖固定数据集的训练方法有区别。在这种方式中,大模型不仅能被动接受数据,还能主动探索周围环境,并与人类交流,来获取知识和技能。

在推荐餐厅时,大模型需深入了解用户偏好,同时能即时收集并分析相关餐厅信息。而且,这种模型还需具备处理不确定性的能力,这与传统模式有较大差异,也是其独特之处。

训练数据竞争的未来走向

目前,闭源或开源的大规模模型正面临数据量的较量。采用RAG、MoE、MTL等创新技术,即便是参数较少的模型,只要其学习的数据量更充足、覆盖的领域更广泛,就有可能超越参数量较多的模型。

未来,竞争将愈发剧烈。开发者必须保证数据充足,同时避免数据资源耗尽。他们还需寻找新的数据渠道,例如合成数据,并努力克服这些数据可能带来的负面影响。这些问题,当前迫切需要解决。

知道了大模型训练所需数据的详情,大家觉得哪个行业最有可能解决训练数据面临的各种挑战?期待大家在评论区积极讨论,也欢迎大家点赞和分享这篇文章。

作者:小蓝

链接:https://www.lanmiyun.com/content/6978.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发