G行大数据上云之路:云技术如何颠覆传统Hadoop架构与提升性能

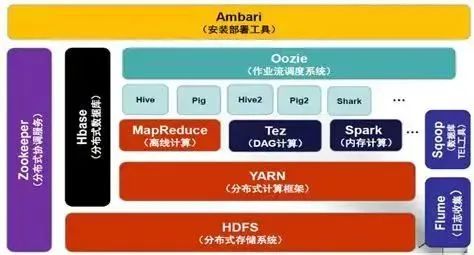

传统大数据集群架构的不足

大数据技术的普及使得集群规模迅速增大,这在传统架构中基于众多物理PC服务器构建的集群中逐渐显现出了问题。以某些大型企业为例,它们的数据量正以几何级数增长,而传统的架构已无法承受这种压力,其扩展性受到限制。具体来看,硬件成本高昂,运维工作繁杂,存储与计算资源不匹配,导致在实际运营中资源被浪费。

在众多行业,尤其是电商在大型促销活动期间,传统的大数据集群处理速度不够快,这影响了用户的使用感受和业务进展,已无法满足当前数据处理的高要求。

大数据上云的架构变革

云技术对大数据产生了深远影响,使得大数据存储与计算得以实现分离,形成新的架构。比如,不少互联网企业已开始运用这种架构,有效提高了资源的使用效率。这一变革有效解决了存储与计算资源不匹配的难题,因为不同业务对存储和计算的需求各异,分离后可以按需进行资源分配。

数据必须通过网络进行传输,这给网络带宽和响应速度带来了极大的考验。特别是在金融交易这类需要实时分析数据的高频交互场景中,一旦网络出现延迟,就可能对决策的准确性造成影响。因此,企业不得不投入大量资金来升级和改善网络设备。

分布式对象存储的兴起

价格亲民,存储量大,且扩展性能出色的分布式对象存储技术,革新了大数据的存储方式。以科技企业的数据中心为例,这种存储技术能够轻松应对数据量的激增。它本身拥有强大的灾备功能,比如采用多站点部署的分布式对象存储,可以有效避免数据丢失的风险。

金融领域对数据安全有着严格的标准,而分布式对象存储的数据中心级容灾功能恰好符合这一要求。在银行系统的大数据管理中应用这一技术,可以有效确保业务的连续性,即便某个数据中心发生故障,业务仍能照常进行。

分布式对象存储在数据湖中的优势

未来,大数据技术将服务于数据湖等应用系统,这些系统主要存储众多小文件。在处理这些小文件时,HDFS显得力不从心,但分布式对象存储却能轻松应对。在科研机构的数据存储中,实验小文件众多,采用分布式对象存储能够实现更高效的管理。

数据在分布式对象存储中通过哈希算法进行管理,元数据与业务数据采用相同的管理模式,并且支持横向扩展。对于互联网企业的数据管理来说,这种管理方式既高效又能支持业务迅速扩张及数据的安全存储。

大数据存算分离的网络问题

云计算环境中,存储与计算相分离,数据传输依赖网络,这导致两个问题。首先,网络基础带宽承受压力增大,尤其是大型企业的数据中心与计算节点间,数据交换频繁,带宽往往紧张。其次,计算所需时间成本上升,在实时数据处理中,计算延迟影响了处理速度。

设计大数据存算分离架构,需对网络带宽需求进行全面考量。若忽视此点,业务扩张后,网络限制将显著降低系统效能。特别是,当集群规模扩大,内存数据交换计算引擎在处理计算任务及网络通信方面仍存在一定难题。

云原生大数据计算引擎的发展

早期的大数据软件主要针对海量数据处理进行设计,并未考虑到分布式系统可能出现的错误情况。随着业务日益复杂,云原生的大数据计算引擎便应运而生。现在,许多云原生软件开始采用gRPC技术来增强通信效率。以科技巨头的云平台为例,它们在数据传输方面表现得更为高效。

网络通讯服务与计算引擎分离,完成了计算与通讯功能的区分。运用网格技术与云技术相结合,云原生大数据处理通信,确保了分布式追踪信息的实现。因此,在处理复杂数据交互时,能够精确了解数据的流动路径及处理步骤。

大家对云原生大数据计算引擎能否彻底取代传统大数据计算方式有何看法?不妨点赞并转发这篇文章,同时欢迎在评论区留言,让我们共同探讨!

作者:小蓝

链接:https://www.lanmiyun.com/content/7808.html

本站部分内容和图片来源网络,不代表本站观点,如有侵权,可联系我方删除。

赶快来坐沙发